Nuova economia keynesiana - New Keynesian economics

| Parte di una serie su |

| Macroeconomia |

|---|

|

| Parte di una serie su |

| Capitalismo |

|---|

La nuova economia keynesiana è una scuola di macroeconomia che si sforza di fornire basi microeconomiche per l'economia keynesiana . Si sviluppò in parte come risposta alle critiche alla macroeconomia keynesiana da parte degli aderenti alla nuova macroeconomia classica .

Due ipotesi principali definiscono l'approccio neokeynesiano alla macroeconomia. Come l'approccio neoclassico, l'analisi macroeconomica neokeynesiana di solito presuppone che le famiglie e le imprese abbiano aspettative razionali . Tuttavia, le due scuole differiscono in quanto l'analisi neokeynesiana di solito presuppone una varietà di fallimenti di mercato . In particolare, i nuovi keynesiani presumono che ci sia una concorrenza imperfetta nella fissazione dei prezzi e dei salari per aiutare a spiegare perché prezzi e salari possono diventare " appiccicosi ", il che significa che non si adattano istantaneamente ai cambiamenti delle condizioni economiche.

La vischiosità dei salari e dei prezzi, e gli altri fallimenti di mercato presenti nei modelli neokeynesiani , implicano che l'economia potrebbe non riuscire a raggiungere la piena occupazione . Pertanto, i nuovi keynesiani sostengono che la stabilizzazione macroeconomica da parte del governo (usando la politica fiscale ) e della banca centrale (usando la politica monetaria ) può portare a un risultato macroeconomico più efficiente di una politica di laissez faire .

Il nuovo keynesismo divenne parte della nuova sintesi neoclassica - che ora viene solitamente indicata semplicemente come economia neokeynesiana - che incorporava parti sia di essa che della nuova macroeconomia classica e costituisce la base teorica della macroeconomia tradizionale di oggi.

Sviluppo dell'economia keynesiana

anni '70

La prima ondata di economia neokeynesiana si sviluppò alla fine degli anni '70. Il primo modello di Sticky Information è stato sviluppato da Stanley Fischer nel suo articolo del 1977, Long-Term Contracts, Rational Expectations, and Optimal Money Supply Rule . Ha adottato un modello contrattuale "sfalsato" o "sovrapposto". Supponiamo che ci siano due sindacati nell'economia, che a turno scelgono i salari. Quando è il turno di un sindacato, sceglie i salari che fisserà per i prossimi due periodi. Ciò contrasta con il modello di John B. Taylor in cui il salario nominale è costante per tutta la durata del contratto, come è stato successivamente sviluppato nei suoi due articoli, uno nel 1979 "Fissazione del salario sfalsato in un modello macro" e uno nel 1980 "Dinamica aggregata". e contratti scaglionati". Entrambi i contratti Taylor e Fischer condividono la caratteristica che solo i sindacati che fissano il salario nel periodo corrente utilizzano le informazioni più recenti: i salari in metà dell'economia riflettono ancora le vecchie informazioni. Il modello Taylor aveva salari nominali appiccicosi in aggiunta alle informazioni appiccicose: i salari nominali dovevano essere costanti per tutta la durata del contratto (due periodi).Queste prime nuove teorie keynesiane erano basate sull'idea di base che, dati i salari nominali fissi, un'autorità monetaria (banca centrale) può controllare il tasso di occupazione Poiché i salari sono fissati a un tasso nominale, l'autorità monetaria può controllare il salario reale (valori salariali adeguati all'inflazione) modificando l'offerta di moneta e quindi influenzare il tasso di occupazione.

anni '80

Costi del menu e concorrenza imperfetta

Negli anni '80 è stato sviluppato il concetto chiave di utilizzare i costi del menu in un quadro di concorrenza imperfetta per spiegare la vischiosità dei prezzi. Il concetto di costo forfettario (costo del menu) per la variazione del prezzo è stato originariamente introdotto da Sheshinski e Weiss (1977) nel loro articolo che esaminava l'effetto dell'inflazione sulla frequenza delle variazioni di prezzo. L'idea di applicarla come teoria generale della rigidità del prezzo nominale è stata avanzata simultaneamente da diversi economisti nel 1985-6. George Akerlof e Janet Yellen avanzano l'idea che a causa della razionalità limitata le aziende non vorranno cambiare il loro prezzo a meno che il beneficio non sia più di una piccola quantità. Questa razionalità limitata porta all'inerzia dei prezzi e dei salari nominali che può portare a fluttuazioni della produzione a prezzi e salari nominali costanti. Gregory Mankiw ha preso l'idea del costo del menu e si è concentrato sugli effetti sul benessere dei cambiamenti nella produzione derivanti dai prezzi vischiosi . Anche Michael Parkin ha avanzato l'idea. Sebbene l'approccio inizialmente si concentrasse principalmente sulla rigidità dei prezzi nominali, è stato esteso a salari e prezzi da Olivier Blanchard e Nobuhiro Kiyotaki nel loro influente articolo Monopolistic Competition and the Effects of Aggregate Demand . Huw Dixon e Claus Hansen hanno dimostrato che anche se i costi del menu si applicassero a un piccolo settore dell'economia, ciò influenzerebbe il resto dell'economia e porterebbe i prezzi nel resto dell'economia a diventare meno reattivi ai cambiamenti della domanda.

Mentre alcuni studi hanno suggerito che i costi del menu sono troppo piccoli per avere un impatto molto aggregato, Laurence M. Ball e David Romer hanno mostrato nel 1990 che le rigidità reali potrebbero interagire con le rigidità nominali per creare uno squilibrio significativo. Le rigidità reali si verificano ogni volta che un'impresa è lenta nell'aggiustare i suoi prezzi reali in risposta a un contesto economico mutevole. Ad esempio, un'impresa può affrontare rigidità reali se ha potere di mercato o se i suoi costi per input e salari sono bloccati da un contratto. Ball e Romer hanno sostenuto che le rigidità reali nel mercato del lavoro mantengono alti i costi di un'impresa, il che rende le imprese riluttanti a tagliare i prezzi e perdere entrate. La spesa creata dalle rigidità reali combinate con il costo del menu di variazione dei prezzi rende meno probabile che l'impresa riduca i prezzi a un livello di compensazione del mercato.

Anche se i prezzi sono perfettamente flessibili, la concorrenza imperfetta può influenzare l'influenza della politica fiscale in termini di moltiplicatore. Huw Dixon e Gregory Mankiw hanno sviluppato indipendentemente semplici modelli di equilibrio generale che mostrano che il moltiplicatore fiscale potrebbe aumentare con il grado di concorrenza imperfetta nel mercato della produzione. La ragione di questo è che la concorrenza imperfetta nel mercato di uscita tende a ridurre il salario reale , portando alla sostituzione domestica distanti consumo verso svago . Quando la spesa pubblica aumenta, il corrispondente aumento della tassazione forfettaria fa diminuire sia il tempo libero che i consumi (assumendo che siano entrambi un bene normale). Maggiore è il grado di concorrenza imperfetta nel mercato della produzione, minore è il salario reale e quindi più la riduzione ricade sul tempo libero (cioè le famiglie lavorano di più) e meno sui consumi. Quindi il moltiplicatore fiscale è minore di uno, ma aumenta nel grado di concorrenza imperfetta nel mercato della produzione.

Il modello dei contratti scaglionati Calvo

Nel 1983 Guillermo Calvo ha scritto "Prezzi sfalsati in un quadro di massimizzazione dell'utilità". L'articolo originale è stato scritto in un quadro matematico a tempo continuo , ma al giorno d'oggi è utilizzato principalmente nella sua versione a tempo discreto . Il modello Calvo è diventato il modo più comune per modellare la rigidità nominale nei nuovi modelli keynesiani. Esiste una probabilità che l'impresa possa azzerare il suo prezzo in un qualsiasi periodo h (l' hazard rate ), o equivalentemente la probabilità ( 1-h ) che il prezzo rimanga invariato in quel periodo (il tasso di sopravvivenza). La probabilità h è talvolta chiamata "probabilità di Calvo" in questo contesto. Nel modello Calvo la caratteristica cruciale è che il price-setter non sa per quanto tempo il prezzo nominale rimarrà in vigore, contrariamente al modello Taylor dove la durata del contratto è nota ex ante.

Mancanza di coordinamento

Il fallimento del coordinamento è stato un altro importante nuovo concetto keynesiano sviluppato come un'altra potenziale spiegazione per le recessioni e la disoccupazione. Nelle recessioni una fabbrica può rimanere inattiva anche se ci sono persone disposte a lavorarci e persone disposte ad acquistare la sua produzione se avessero un lavoro. In uno scenario del genere, le flessioni economiche sembrano essere il risultato di un fallimento del coordinamento: la mano invisibile non riesce a coordinare il flusso abituale, ottimale, di produzione e consumo. L'articolo del 1988 di Russell Cooper e Andrew John Coordinating Coordination Failures in Keynesian Models esprimeva una forma generale di coordinamento come modelli con equilibri multipli in cui gli agenti potevano coordinarsi per migliorare (o almeno non danneggiare) ciascuna delle loro rispettive situazioni. Cooper e John hanno basato il loro lavoro su modelli precedenti, incluso il modello del cocco di Peter Diamond del 1982 , che ha dimostrato un caso di fallimento della coordinazione che coinvolge la teoria della ricerca e dell'abbinamento . Nel modello di Diamond è più probabile che i produttori producano se vedono altri produrre. L'aumento dei possibili partner commerciali aumenta la probabilità che un dato produttore trovi qualcuno con cui commerciare. Come in altri casi di fallimento della coordinazione, il modello di Diamond ha equilibri multipli e il benessere di un agente dipende dalle decisioni degli altri. Il modello di Diamond è un esempio di " esternalità di mercato spesso " che fa funzionare meglio i mercati quando più persone e aziende vi partecipano. Altre potenziali fonti di fallimento della coordinazione includono le profezie che si autoavverano . Se un'azienda prevede un calo della domanda, potrebbe ridurre le assunzioni. La mancanza di posti di lavoro potrebbe preoccupare i lavoratori che poi riducono i loro consumi. Questo calo della domanda soddisfa le aspettative dell'impresa, ma è interamente dovuto alle azioni dell'impresa stessa.

Fallimenti del mercato del lavoro: salari di efficienza

I nuovi keynesiani hanno offerto spiegazioni per il fallimento del mercato del lavoro. In un mercato walrasiano, i lavoratori disoccupati abbassano i salari fino a quando la domanda di lavoratori incontra l'offerta. Se i mercati sono walrasiani, i ranghi dei disoccupati sarebbero limitati ai lavoratori che passano da un lavoro all'altro e ai lavoratori che scelgono di non lavorare perché i salari sono troppo bassi per attirarli. Hanno sviluppato diverse teorie che spiegano perché i mercati potrebbero lasciare disoccupati i lavoratori volenterosi. La più importante di queste teorie, i nuovi keynesiani, era la teoria del salario di efficienza utilizzata per spiegare gli effetti a lungo termine della precedente disoccupazione , in cui gli aumenti a breve termine della disoccupazione diventano permanenti e portano a livelli più elevati di disoccupazione nel lungo periodo.

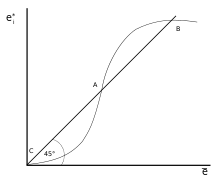

Nei modelli salariali di efficienza, i lavoratori sono pagati a livelli che massimizzano la produttività invece di liberare il mercato. Ad esempio, nei paesi in via di sviluppo, le aziende potrebbero pagare più di un tasso di mercato per garantire che i loro lavoratori possano permettersi un'alimentazione sufficiente per essere produttivi. Le aziende potrebbero anche pagare salari più alti per aumentare la lealtà e il morale, possibilmente portando a una migliore produttività. Le imprese possono anche pagare salari più alti di quelli di mercato per prevenire l'abbandono. I modelli che si sottraevano erano particolarmente influenti. Il documento del 1984 di Carl Shapiro e Joseph Stiglitz Equilibrium Unemployment as a Worker Discipline Device ha creato un modello in cui i dipendenti tendono a evitare il lavoro a meno che le aziende non possano monitorare lo sforzo dei lavoratori e minacciare di perdere i dipendenti con la disoccupazione. Se l'economia è a pieno regime, uno schivato licenziato si sposta semplicemente verso un nuovo lavoro. Le singole imprese pagano ai propri lavoratori un premio rispetto al tasso di mercato per garantire che i loro lavoratori preferiscano lavorare e mantenere il loro lavoro attuale invece di sottrarsi e rischiare di doversi trasferire a un nuovo lavoro. Poiché ogni impresa paga più dei salari di compensazione del mercato, il mercato del lavoro aggregato non riesce a compensare. Questo crea un pool di lavoratori disoccupati e si aggiunge alle spese per essere licenziati. I lavoratori non solo rischiano un salario più basso, ma rischiano di rimanere bloccati nel bacino dei disoccupati. Mantenere i salari al di sopra dei livelli di compensazione del mercato crea un serio disincentivo alla sottrazione che rende i lavoratori più efficienti anche se lascia disoccupati alcuni lavoratori volenterosi.

anni '90

La nuova sintesi neoclassica

All'inizio degli anni '90, gli economisti iniziarono a combinare gli elementi della nuova economia keynesiana sviluppati negli anni '80 e prima con la teoria del ciclo economico reale . I modelli RBC erano dinamici ma presumevano una concorrenza perfetta; i nuovi modelli keynesiani erano principalmente statici, ma basati su una concorrenza imperfetta. La Nuova sintesi neoclassica combinava essenzialmente gli aspetti dinamici dei globuli rossi con la concorrenza imperfetta e le rigidità nominali dei nuovi modelli keynesiani. Tack Yun è stato uno dei primi a farlo, in un modello che utilizzava il modello di prezzo Calvo . Goodfriend e King hanno proposto un elenco di quattro elementi centrali per la nuova sintesi: ottimizzazione intertemporale, aspettative razionali, concorrenza imperfetta e costosi aggiustamenti dei prezzi (costi del menu). Goodfriend e King scoprono anche che i modelli di consenso producono alcune implicazioni politiche: mentre la politica monetaria può influenzare la produzione reale nel breve periodo, ma non c'è alcun compromesso nel lungo periodo: la moneta non è neutrale nel breve periodo ma è a lungo termine. L'inflazione ha effetti negativi sul benessere. È importante che le banche centrali mantengano la credibilità attraverso politiche basate su regole come l'inflation targeting.

Regola di Taylor

Nel 1993, John B Taylor ha formulato l'idea di una regola di Taylor , che è un'approssimazione in forma ridotta della reattività del tasso di interesse nominale , come stabilito dalla banca centrale , alle variazioni dell'inflazione, della produzione o di altre condizioni economiche. In particolare, la norma descrive come, per ogni aumento dell'uno per cento dell'inflazione, la banca centrale tenda ad aumentare il tasso di interesse nominale di oltre un punto percentuale. Questo aspetto della regola è spesso chiamato principio di Taylor . Sebbene tali regole forniscano proxy concise e descrittive per la politica della banca centrale, in pratica non sono considerate esplicitamente in modo proscrittivo dalle banche centrali quando fissano i tassi nominali.

La versione originale della regola di Taylor descrive come il tasso di interesse nominale risponde alle divergenze dei tassi di inflazione effettivi dai tassi di inflazione target e del prodotto interno lordo (PIL) effettivo dal PIL potenziale :

In questa equazione, è il tasso di interesse nominale a breve termine target (ad esempio il tasso sui fondi federali negli Stati Uniti, il tasso di base della Banca d'Inghilterra nel Regno Unito), è il tasso di inflazione misurato dal deflatore del PIL , è il tasso desiderato dell'inflazione, è il tasso di interesse reale di equilibrio ipotizzato, è il logaritmo del PIL reale ed è il logaritmo del prodotto potenziale , determinato da un andamento lineare.

La nuova curva di Phillips keynesiana

La curva di Phillips del Nuovo Keynesiano è stata originariamente derivata da Roberts nel 1995 e da allora è stata utilizzata nella maggior parte dei modelli DSGE del Nuovo Keynesiano all'avanguardia. La nuova curva di Phillips keynesiana afferma che l'inflazione di questo periodo dipende dalla produzione corrente e dalle aspettative dell'inflazione del periodo successivo. La curva è derivata dal modello dinamico di pricing Calvo e in termini matematici è:

Le aspettative t del periodo corrente dell'inflazione del periodo successivo sono incorporate come , dove è il fattore di sconto. La costante cattura la risposta dell'inflazione alla produzione ed è in gran parte determinata dalla probabilità di variazione del prezzo in qualsiasi periodo, che è :

- .

Meno rigidi sono i prezzi nominali (più alto è ), maggiore è l'effetto della produzione sull'inflazione corrente.

La scienza della politica monetaria

Le idee sviluppate negli anni '90 sono state messe insieme per sviluppare il nuovo equilibrio generale stocastico dinamico keynesiano utilizzato per analizzare la politica monetaria. Ciò è culminato nel nuovo modello keynesiano a tre equazioni trovato nel sondaggio di Richard Clarida , Jordi Gali e Mark Gertler nel Journal of Economic Literature . Combina le due equazioni della nuova curva Keynesiana di Phillips e la regola di Taylor con la curva IS dinamica derivata dall'equazione del consumo dinamico ottimale ( equazione di Eulero delle famiglie).

Queste tre equazioni hanno formato un modello relativamente semplice che potrebbe essere utilizzato per l'analisi teorica delle questioni politiche. Tuttavia, il modello è stato semplificato eccessivamente per alcuni aspetti (ad esempio, non ci sono capitali o investimenti). Inoltre, non funziona bene empiricamente.

anni 2000

Nel nuovo millennio ci sono stati diversi progressi nella nuova economia keynesiana.

L'introduzione di mercati del lavoro imperfettamente competitivi

Mentre i modelli degli anni '90 si concentravano sui prezzi vischiosi nel mercato della produzione, nel 2000 Christopher Erceg, Dale Henderson e Andrew Levin adottarono il modello Blanchard e Kiyotaki dei mercati del lavoro sindacalizzati combinandolo con l'approccio dei prezzi Calvo e lo introdussero in un nuovo modello keynesiano modello DSGE.

Lo sviluppo di modelli DSGE complessi.

Per avere modelli che funzionassero bene con i dati e potessero essere utilizzati per simulazioni di politiche, sono stati sviluppati nuovi modelli keynesiani piuttosto complicati con diverse caratteristiche. Documenti fondamentali sono stati pubblicati da Frank Smets e Rafael Wouters e anche da Lawrence J. Christiano , Martin Eichenbaum e Charles Evans. Le caratteristiche comuni di questi modelli includevano:

- persistenza dell'abitudine. L'utilità marginale del consumo dipende dal consumo passato.

- Prezzi Calvo sia nei mercati di produzione che in quelli dei prodotti, con indicizzazione in modo che quando salari e prezzi non vengono azzerati in modo esplicito, vengono aggiornati per l'inflazione.

- costi di aggiustamento del capitale e impiego di capitale variabile .

- nuovi shock

- shock della domanda, che incidono sull'utilità marginale del consumo

- shock di markup che influenzano il markup desiderato del prezzo rispetto al costo marginale.

- la politica monetaria è rappresentata da una regola di Taylor.

- Metodi di stima bayesiani .

Informazioni appiccicose

L'idea di informazioni adesive trovate nel modello di Fischer è stata successivamente sviluppata da Gregory Mankiw e Ricardo Reis . Questo ha aggiunto una nuova caratteristica al modello di Fischer: c'è una probabilità fissa che tu possa riprogrammare i tuoi salari o prezzi ogni periodo. Utilizzando i dati trimestrali, hanno assunto un valore del 25%: ovvero ogni trimestre il 25% delle imprese/sindacati scelti a caso può pianificare una traiettoria dei prezzi attuali e futuri sulla base delle informazioni correnti. Quindi se consideriamo il periodo in corso: il 25% dei prezzi sarà basato sulle ultime informazioni disponibili; il resto sulle informazioni che erano disponibili l'ultima volta che sono stati in grado di riprogrammare la traiettoria dei prezzi. Mankiw e Reis hanno scoperto che il modello delle informazioni adesive fornisce un buon modo per spiegare la persistenza dell'inflazione.

I modelli informativi appiccicosi non hanno rigidità nominale: le imprese oi sindacati sono liberi di scegliere prezzi o salari diversi per ogni periodo. Sono le informazioni che sono appiccicose, non i prezzi. Pertanto, quando un'impresa è fortunata e può riprogrammare i suoi prezzi attuali e futuri, sceglierà una traiettoria di quelli che ritiene saranno i prezzi ottimali ora e in futuro. In generale, ciò comporterà l'impostazione di un prezzo diverso ogni periodo coperto dal piano. Questo è in contrasto con l'evidenza empirica sui prezzi. Ora ci sono molti studi sulla rigidità dei prezzi in diversi paesi: Stati Uniti, zona euro, Regno Unito e altri. Tutti questi studi mostrano che mentre ci sono alcuni settori in cui i prezzi cambiano frequentemente, ci sono anche altri settori in cui i prezzi rimangono fissi nel tempo. La mancanza di prezzi appiccicosi nel modello informativo appiccicoso è incoerente con il comportamento dei prezzi nella maggior parte dell'economia. Ciò ha portato a tentativi di formulare un modello di "doppia viscosità" che combina informazioni appiccicose con prezzi appiccicosi.

anni 2010

Gli anni 2010 hanno visto lo sviluppo di modelli che incorporano l'eterogeneità familiare nel quadro standard del Nuovo Keynesiano, comunemente indicati come modelli "HANK" (Heterogeneous Agent New Keynesian). Oltre ai prezzi vischiosi, un tipico modello HANK presenta un rischio di reddito da lavoro idiosincratico non assicurabile che dà luogo a una distribuzione della ricchezza non degenerata. I primi modelli con queste due caratteristiche includono Oh e Reis (2012), McKay e Reis (2016) e Guerrieri e Lorenzoni (2017).

Il nome "modello HANK" è stato coniato da Greg Kaplan , Benjamin Moll e Gianluca Violante in un documento del 2018 che inoltre modella le famiglie come l'accumulo di due tipi di beni, uno liquido e l'altro illiquido. Ciò si traduce in una ricca eterogeneità nella composizione del portafoglio tra le famiglie. In particolare, il modello si adatta all'evidenza empirica presentando un'ampia quota di famiglie che detengono poca ricchezza liquida: le famiglie 'alla mano'. Coerentemente con l'evidenza empirica, circa i due terzi di queste famiglie detengono quantità non banali di ricchezza illiquida, nonostante detengano poca ricchezza liquida. Queste famiglie sono conosciute come famiglie ricche alla giornata, un termine introdotto in uno studio del 2014 sulle politiche di stimolo fiscale di Kaplan e Violante.

L'esistenza di famiglie facoltose alla giornata nei modelli neokeynesiani è importante per gli effetti della politica monetaria, perché il comportamento di consumo di quelle famiglie è fortemente sensibile alle variazioni del reddito disponibile, piuttosto che alle variazioni del tasso di interesse (cioè il prezzo del consumo futuro rispetto al consumo attuale). Il corollario diretto è che la politica monetaria viene trasmessa principalmente attraverso effetti di equilibrio generale che funzionano attraverso il reddito da lavoro familiare, piuttosto che attraverso la sostituzione intertemporale, che è il principale canale di trasmissione nei modelli New Keynesian (RANK) dell'agente rappresentativo.

Ci sono due implicazioni principali per la politica monetaria. In primo luogo, la politica monetaria interagisce fortemente con la politica fiscale, a causa del fallimento dell'Equivalenza Ricardiana dovuto alla presenza di famiglie alla giornata. In particolare, le variazioni del tasso di interesse spostano il vincolo di bilancio del governo e la risposta fiscale a questo spostamento incide sul reddito disponibile delle famiglie. In secondo luogo, gli shock monetari aggregati non sono neutri dal punto di vista distributivo poiché influenzano il rendimento del capitale, che colpisce in modo diverso le famiglie con diversi livelli di ricchezza e attività.

Implicazioni politiche

I nuovi economisti keynesiani concordano con gli economisti neoclassici che nel lungo periodo vale la dicotomia classica : i cambiamenti nell'offerta di moneta sono neutri . Tuttavia, poiché i prezzi sono vischiosi nel modello neokeynesiano, un aumento dell'offerta di moneta (o equivalentemente, una diminuzione del tasso di interesse) aumenta la produzione e riduce la disoccupazione nel breve periodo. Inoltre, alcuni modelli neokeynesiani confermano la non neutralità della moneta sotto diverse condizioni.

Tuttavia, gli economisti neokeynesiani non sostengono l'uso di una politica monetaria espansiva per guadagni di breve periodo in produzione e occupazione, poiché aumenterebbe le aspettative inflazionistiche e quindi accumulerebbe problemi per il futuro. Invece, sostengono l'uso della politica monetaria per la stabilizzazione . Cioè, non è consigliabile aumentare improvvisamente l'offerta di moneta solo per produrre un boom economico temporaneo, poiché eliminare le crescenti aspettative inflazionistiche sarà impossibile senza produrre una recessione.

Tuttavia, quando l'economia è colpita da uno shock esterno imprevisto, può essere una buona idea compensare gli effetti macroeconomici dello shock con la politica monetaria. Ciò è particolarmente vero se lo shock inatteso è uno (come un calo della fiducia dei consumatori) che tende a ridurre sia la produzione che l'inflazione; in tal caso, l'espansione dell'offerta di moneta (abbassando i tassi di interesse) aiuta aumentando la produzione stabilizzando l'inflazione e le aspettative inflazionistiche.

Gli studi sulla politica monetaria ottimale nei nuovi modelli DSGE keynesiani si sono concentrati sulle regole del tasso di interesse (in particolare le " regole di Taylor "), specificando come la banca centrale dovrebbe regolare il tasso di interesse nominale in risposta alle variazioni dell'inflazione e della produzione. (Più precisamente, le regole ottimali di solito reagiscono alle variazioni dell'output gap , piuttosto che alle variazioni dell'output in sé .) In alcuni semplici modelli DSGE neokeynesiani, risulta che stabilizzare l'inflazione è sufficiente, perché mantenere un'inflazione perfettamente stabile stabilizza anche la produzione e l'occupazione al massimo grado desiderabile. Blanchard e Galí hanno chiamato questa proprietà la 'coincidenza divina'.

Tuttavia, mostrano anche che nei modelli con più di un'imperfezione di mercato (ad esempio, attriti nell'aggiustamento del livello di occupazione, così come prezzi vischiosi), non c'è più una "coincidenza divina", ma c'è invece un compromesso tra stabilizzazione inflazione e stabilizzazione dell'occupazione. Inoltre, mentre alcuni macroeconomisti ritengono che i nuovi modelli keynesiani siano sul punto di essere utili per consigli di politica quantitativa trimestrale, esiste il disaccordo.

Recentemente, è stato dimostrato che la coincidenza divina non vale necessariamente nella forma non lineare del modello standard neokeynesiano. Questa proprietà sarebbe valida solo se l'autorità monetaria è impostata per mantenere il tasso di inflazione esattamente allo 0%. A qualsiasi altro obiettivo desiderato per il tasso di inflazione, c'è un compromesso endogeno, anche in assenza di reali imperfezioni come salari appiccicosi, e la coincidenza divina non regge più.

Relazione con altre scuole macroeconomiche

Nel corso degli anni, una serie di "nuove" teorie macroeconomiche legate o opposte al keynesismo hanno avuto influenza. Dopo la seconda guerra mondiale , Paul Samuelson usò il termine sintesi neoclassica per riferirsi all'integrazione dell'economia keynesiana con l'economia neoclassica . L'idea era che il governo e la banca centrale avrebbero mantenuto la piena occupazione approssimativa, in modo che le nozioni neoclassiche , incentrate sull'assioma dell'universalità della scarsità , si applicassero. John Hicks ' IS / LM modello è stato fondamentale per la sintesi neoclassica.

Il lavoro successivo di economisti come James Tobin e Franco Modigliani che ha dato maggiore enfasi ai microfondamenti del consumo e degli investimenti è stato talvolta chiamato neo-keynesismo . Viene spesso contrapposto al post-keynesismo di Paul Davidson , che sottolinea il ruolo dell'incertezza fondamentale nella vita economica, soprattutto per quanto riguarda le questioni degli investimenti fissi privati .

Il nuovo keynesismo fu una risposta a Robert Lucas e alla nuova scuola classica . Quella scuola criticava le incongruenze del keynesismo alla luce del concetto di " aspettative razionali ". I nuovi classici combinavano un equilibrio unico di compensazione del mercato (a piena occupazione ) con aspettative razionali. I nuovi keynesiani hanno usato "microfondamenti" per dimostrare che la vischiosità dei prezzi impedisce ai mercati di compensare. Pertanto, l'equilibrio razionale basato sulle aspettative non deve essere unico.

Mentre la sintesi neoclassica sperava che la politica fiscale e monetaria mantenesse la piena occupazione , i nuovi classici presumevano che l'adeguamento dei prezzi e dei salari avrebbe automaticamente raggiunto questa situazione nel breve periodo. I nuovi keynesiani, d'altra parte, vedevano la piena occupazione come raggiunta automaticamente solo nel lungo periodo, poiché i prezzi sono "appiccicosi" nel breve periodo. Le politiche del governo e della banca centrale sono necessarie perché il "lungo periodo" può essere molto lungo.

In definitiva, le differenze tra la nuova macroeconomia classica e la nuova economia keynesiana sono state risolte nella nuova sintesi neoclassica degli anni '90, che costituisce la base dell'economia tradizionale oggi, e l'accento keynesiano sull'importanza del coordinamento centralizzato delle politiche macroeconomiche (ad esempio, monetario e stimolo fiscale), istituzioni economiche internazionali come la Banca mondiale e il Fondo monetario internazionale (FMI) e del mantenimento di un sistema commerciale controllato è stato evidenziato durante la crisi finanziaria ed economica globale del 2008. Ciò si è riflesso nel lavoro degli economisti del FMI e di Donald Markwell .

Principali economisti neokeynesiani

Guarda anche

- Contratti Calvo (sfalsati)

- 2008-2009 rinascita keynesiana

- Nuova sintesi neoclassica

- Prezzi appiccicosi

- Costo del benessere dei cicli economici

- Contratti Taylor (economia)

Riferimenti

Ulteriori letture

- Clarida, Riccardo; Galí, Jordi; Gertler, Mark (1999). "La scienza della politica monetaria: una nuova prospettiva keynesiana". Giornale di letteratura economica . 37 (4): 1661–1707. CiteSeerX 10.1.1.199.3912 . doi : 10.1257/jel.37.4.1661 . JSTOR 2565488 . S2CID 55045787 .

- Robert J. Gordon Gordon, Robert (1990), Che cos'è l'economia neokeynesiana?, Journal of Economic Literature .

- Dixon, Huw (2008), New Keynesian Economics, New Palgrave Dictionary of Economics Nuova macroeconomia keynesiana. doi : 10.1057/9780230226203.1184 .

- Mankiw, N. Gregory (2008). "Nuova economia keynesiana" . In David R. Henderson (ed.). Enciclopedia concisa di economia (2a ed.). Indianapolis: Biblioteca di Economia e Libertà . ISBN 978-0865976658. OCLC 237794267 .

- Rowe, Nick. "Le fasi di crescita del nuovo modello keynesiano" . Iniziativa canadese utile . Estratto il 24 luglio 2014 .

![\pi _{{t}}=\beta E_{{t}}[\pi _{{t+1}}]+\kappa y_{{t}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/0ef7dd57c38352c58215d6a0a3e102a4218956f6)

![\beta E_{{t}}[\pi _{{t+1}}]](https://wikimedia.org/api/rest_v1/media/math/render/svg/665311ff5571a987a4e48a2435270b77aa595d37)

![\kappa ={\frac {h[1-(1-h)\beta ]}{1-h}}\gamma](https://wikimedia.org/api/rest_v1/media/math/render/svg/c91590f920d1dc4d17ea89f5ce58c14b50261a9a)